Pipeline Builder: Orquesta Visualmente las Transformaciones de Datos

Los pipelines de datos como “caja negra” son una fuente principal de problemas de calidad de datos. Cuando la lógica de transformación está atrapada en miles de líneas de scripts SQL desconectados, se vuelve difícil de depurar, imposible para los interesados entender, y una pesadilla de mantener.

Arkham's Pipeline Builder is engineered to solve this. It replaces opaque, imperative scripts with a transparent, visual canvas for orchestrating complex data transformations. Here, you build pipelines by composing powerful transformations in an interactive graph, where data lineage is explicit and automatically tracked. This allows builders to move from raw, staging datasets to production-ready assets with unparalleled clarity and speed.

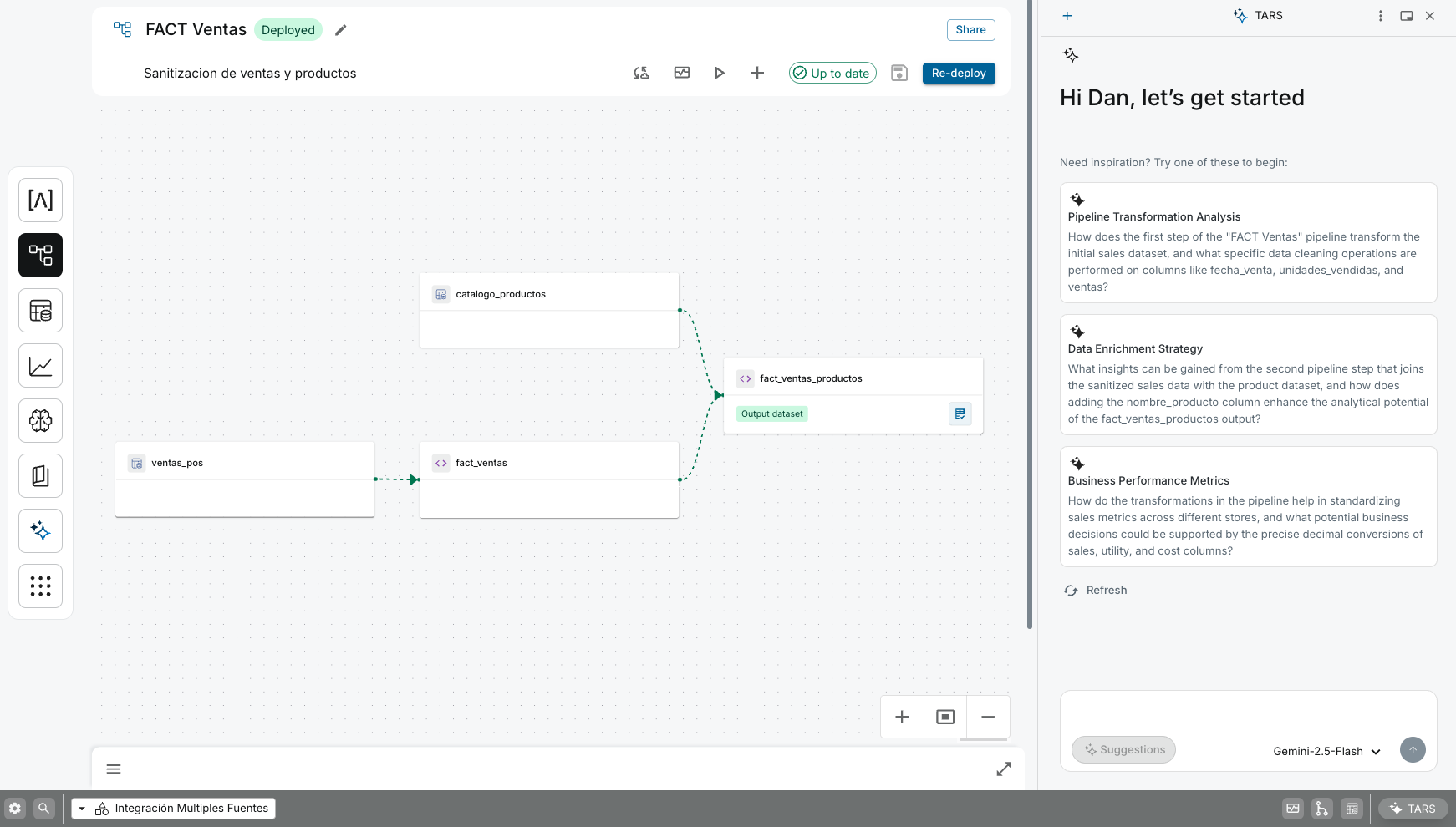

Our Pipeline Builder's visual canvas, where builders orchestrate transformations as a graph, making data lineage explicit and simplifying the development of complex data workflows.

Cómo Funciona: Un Flujo de Trabajo Basado en Nodos

El Pipeline Builder representa toda tu lógica de transformación como un grafo dirigido acíclico (DAG). Cada nodo en el grafo es un conjunto de datos, y cada conexión representa una transformación que crea un nuevo conjunto de datos a partir de sus nodos padres.

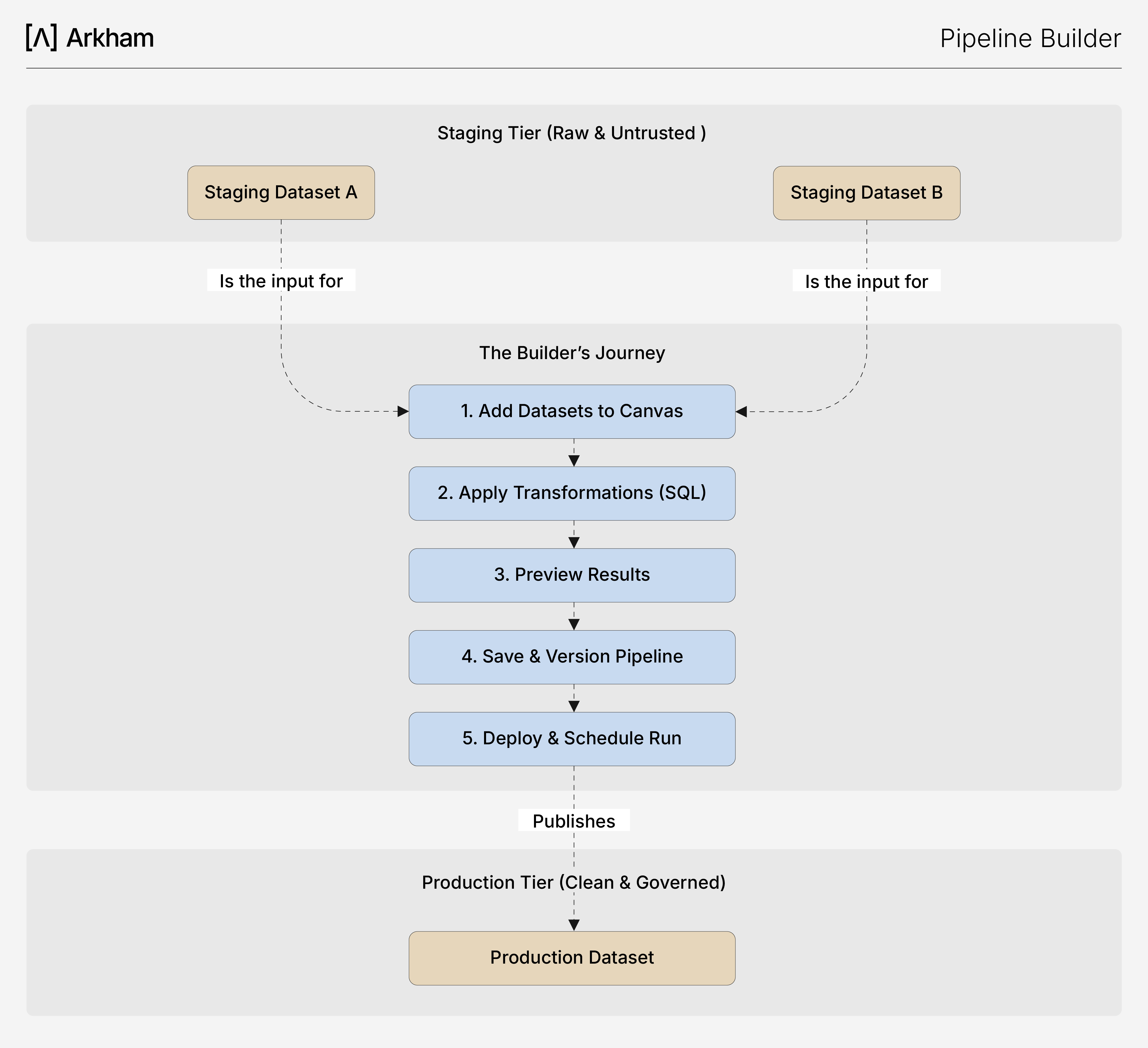

- Agrega Datasets: Comienzas agregando datasets existentes desde el Catálogo de Datos al lienzo. Típicamente, tu recorrido iniciará con los datasets de preparación creados por los Conectores

- Apply Transformations: Selecciona nodos fuente y elige una transformación. Puedes usar un asistente guiado por UI para operaciones comunes como joins y unions, o escribir una consulta SQL personalizada en el editor embebido para lógica más compleja. El editor soporta referencias a otros nodos en el pipeline (por ejemplo, SELECT * FROM @forecast_sales).

SELECT * FROM @forecast_sales). - Preview and Iterate: Before committing, you can instantly preview the results of your transformation. Our platform uses a session compute cluster to run the query on sample data, allowing you to validate your logic in real-time.

- Save and Version: Once you are satisfied with the preview, you apply the step, which creates a new dataset node on the canvas. Saving the pipeline creates a new, immutable version, ensuring that your work is tracked and reproducible.

- Deploy: When your pipeline is complete, you deploy a specific version. The deployed version can be run manually or set to execute on a recurring schedule, publishing a clean, validated Production Dataset to our Data Catalog.

🤖 Transformación asistida por AI con TARS

En este paso, puede pedirle a TARS que acelere su trabajo generando SQL complejo para usted. En lugar de escribir la consulta manualmente, puede proporcionar un mensaje como:

“Sugerir una consulta SQL para unirse@dataset_Aand@dataset_Bon the user_id column, and filter for users in Mexico."

This diagram outlines the five-step builder's journey in our Pipeline Builder, from adding raw Staging data to the canvas to deploying a versioned pipeline that publishes a trusted Production dataset.

Principales Beneficios Técnicos

- Accelerated Development: La interfaz visual y las previsualizaciones en vivo reducen drásticamente el tiempo de desarrollo. Lo que antes requería ciclos de codificación, ejecución y depuración ahora puede hacerse en minutos.

- Clarity and Lineage: La vista basada en grafos facilita la comprensión incluso de los pipelines más complejos. La trazabilidad de datos es explícita y se rastrea automáticamente, simplificando la depuración y el análisis de impacto.

- Reproducibility and Governance: Cada cambio guardado crea una nueva versión inmutable del pipeline. Siempre puedes regresar a una versión anterior o inspeccionar la lógica exacta que produjo un conjunto de datos, garantizando auditoría completa.

- Scalability: Aunque la interfaz es visual, la ejecución no lo es. Cuando despliegas un pipeline, Arkham lo ejecuta en un motor de cómputo escalable y gestionado, capaz de procesar terabytes de datos de forma eficiente.

Capacidades Relacionadas

- Data Platform Overview: Observa cómo el Pipeline Builder encaja en el flujo de datos de extremo a extremo.

- : La fuente de tus datasets de entrada y el destino para tus nuevos activos de nivel producción.

- Conectores: El proceso inicial que ingiere los datos en bruto de preparación que usas en tus pipelines.The upstream process that ingests the raw Staging data used in your pipelines.

- Playground: El lugar ideal para consultar, explorar y validar los nuevos conjuntos de datos de Producción que has creado.The ideal place to query, explore, and validate the new Production datasets you've created.

- TARS: Tu copiloto de IA para generar SQL, depurar errores y verificar el estado del pipeline.Your AI co-pilot for generating SQL with Trino Dialect, debugging errors, and checking pipeline status.