ML Hub: Un Entorno de Libretas para ML en Producción

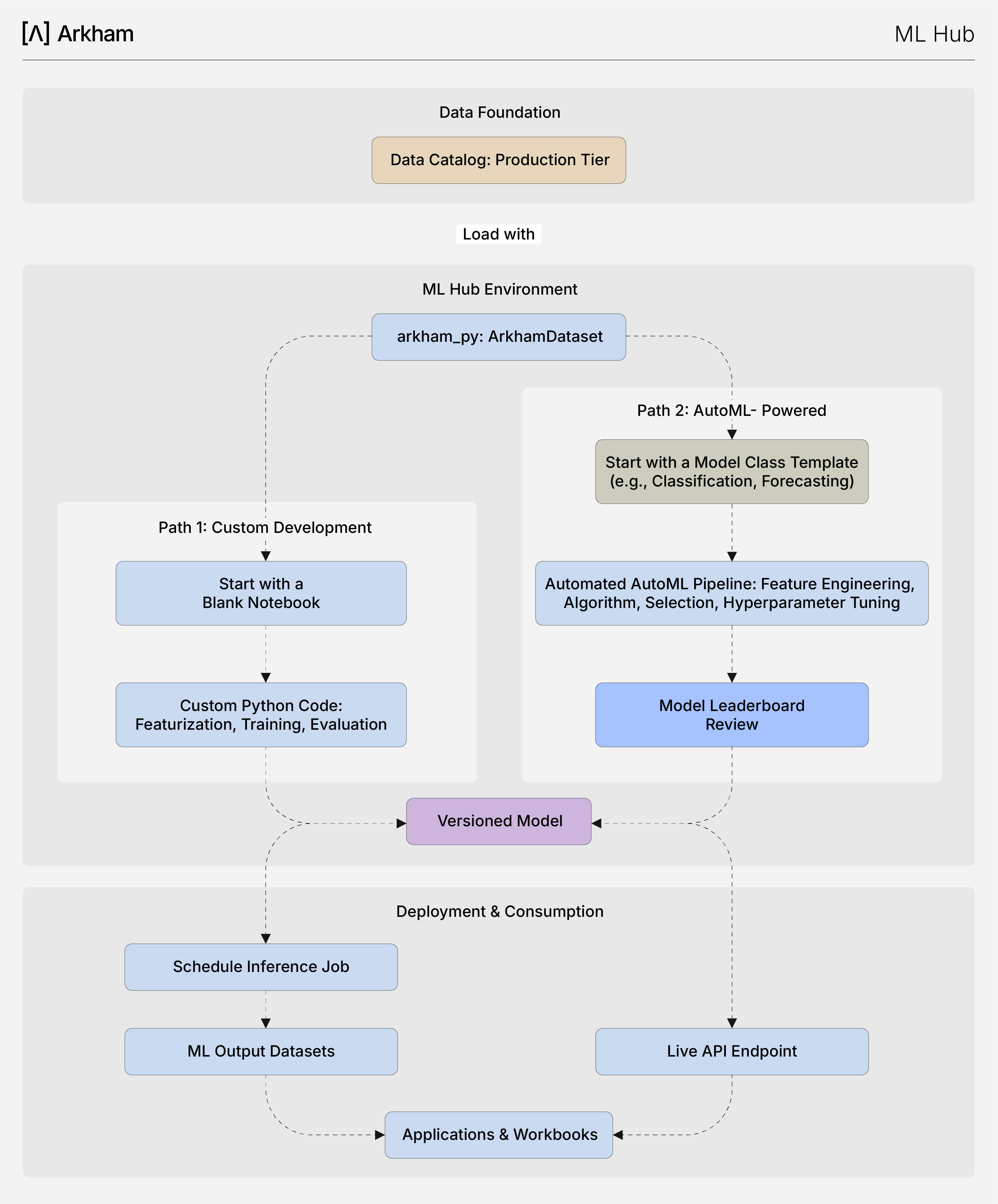

La plataforma de IA de Arkham proporciona un potente entorno AutoML basado en el código, diseñado para equilibrar la automatización con el control del desarrollador. Se accede mediante programación a través de **ArkHampy**, nuestro SDK de Python, y está construido sobre una biblioteca transparente de **Clases Modelo**. Este enfoque le permite crear rápidamente modelos de línea base sólidos y realizar una transición sin problemas a un desarrollo personalizado detallado.

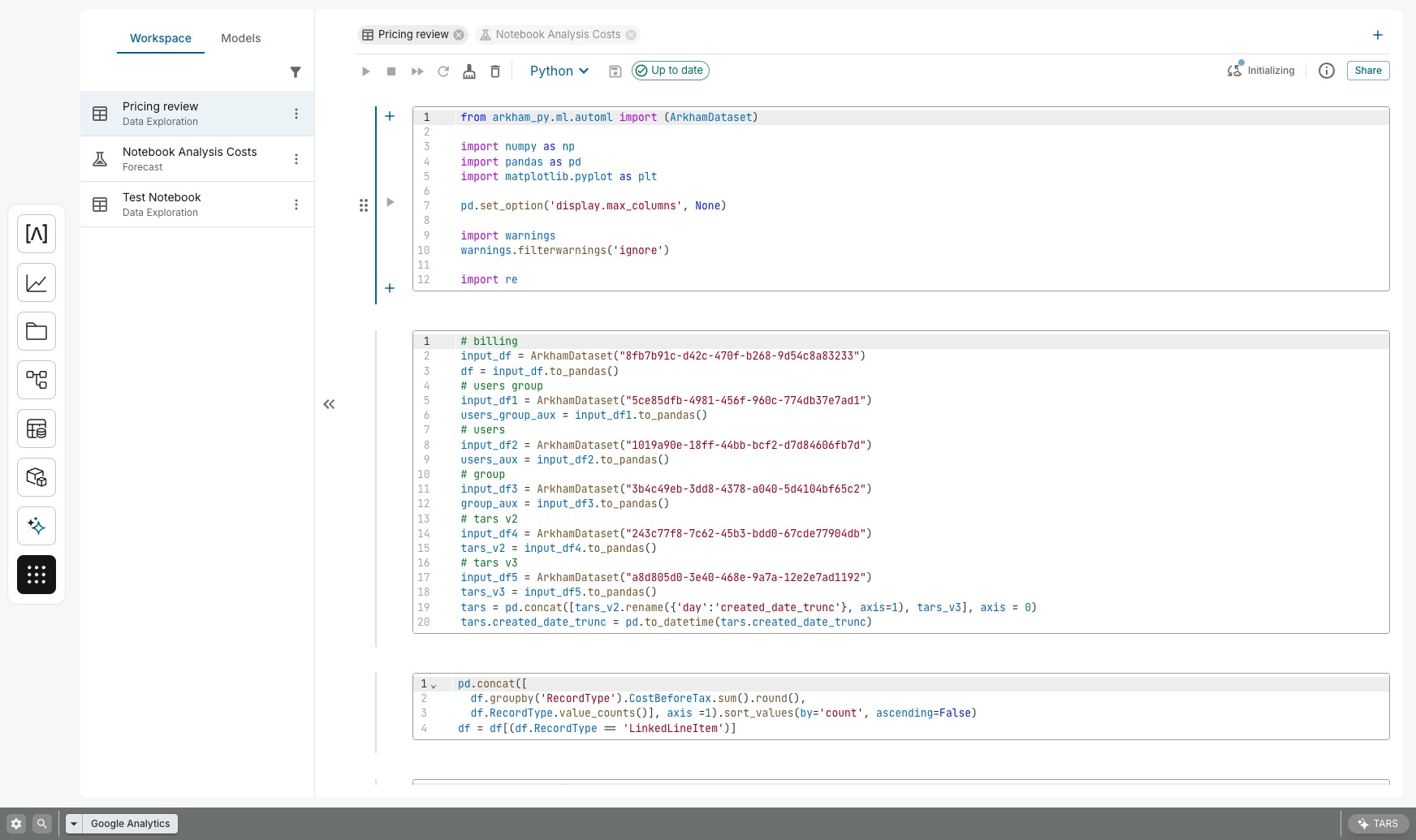

Arkham's ML Hub is engineered to eliminate this friction. It provides a powerful, Python-based notebook interface that is deeply integrated with the rest of the Arkham platform. Here, you can move seamlessly from data preparation to deployment within a single, governed environment, using either custom code or our accelerated AutoML frameworks.

El flujo de trabajo Pro-Code

Todo el ciclo de vida de ML se administra dentro de un entorno basado en código, lo que brinda a los científicos de datos el máximo control y reproducibilidad. Utiliza `ArkHampy` para orquestar el acceso a los datos, la configuración del modelo y el entrenamiento.

El núcleo del marco combina la biblioteca `Clase Modelo` con la canalización de capacitación automatizada. Este proceso está diseñado para lograr velocidad y eficiencia:

- Seleccione una clase de modelo: Elija entre una biblioteca curada de más de 10 plantillas preconstruidas de grado de producción para casos de uso comunes (por ejemplo, pronóstico, clasificación). Estas son plantillas de “caja de vidrio”, no cajas negras.

- Configurar en código: Usando `ArkHampy`, conectas tu conjunto de datos desde Lakehouse y configuras los parámetros del modelo.

- Lanzamiento de AutoML Pipeline: Activar la canalización automatizada, que maneja las partes más complejas del ciclo de vida de ML: preprocesamiento de datos, ingeniería de características, selección de algoritmos y ajuste de hiperparámetros.

- Revisión e implementación: El pipeline produce una tabla de clasificación de los modelos de mejor rendimiento. Puede revisar sus métricas, inspeccionar sus configuraciones e implementar el modelo elegido en el Registro de modelos con un solo comando.

Cómo mejora su ciclo de vida de ML

Este enfoque integrado, basado en el código, proporciona varias ventajas clave para los constructores técnicos:

- Líneas de base aceleradas: Genere modelos de línea base de alto rendimiento en horas, no semanas. Esto proporciona valor inmediato y establece un punto de referencia de rendimiento claro para cualquier otra afinación o investigación personalizada.

- Obliga las mejores prácticas: Las clases de modelo encapsulan arquitecturas probadas, evitando que los equipos “reinventen la rueda”. Esto asegura que todos los proyectos comiencen desde una base sólida, escalable y gobernable.

- MLOPs unificados: Ya sea que un modelo sea la salida directa del pipeline AutoML o una solución altamente personalizada, se registra, versiona, implementa y supervisa a través de la misma infraestructura MLOPS unificada, lo que garantiza la consistencia y confiabilidad desde la experimentación hasta la producción.

- Máxima flexibilidad: Nunca está bloqueado en una interfaz de usuario restrictiva. El SDK `ArkHampy` le permite ampliar, anular o crear soluciones completamente a medida cuando una clase de modelo no se ajusta a sus necesidades.