Data Lakehouse: La Fundación para Tu Flujo de Trabajo

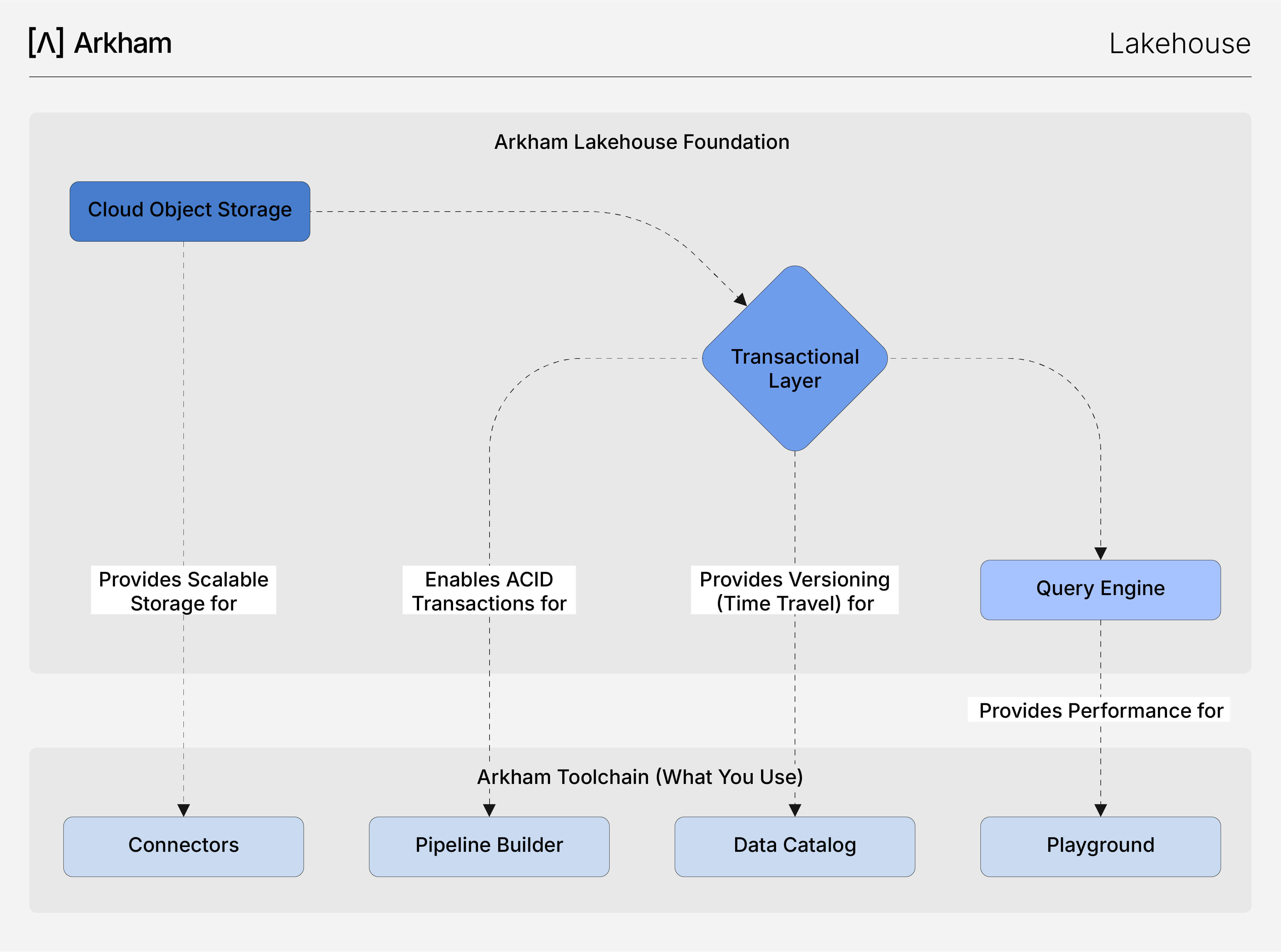

Nuestro Arkham Data Lakehouse es el motor de alto rendimiento que sustenta toda la Plataforma de Datos. Combina la enorme escala de un data lake con la confiabilidad y rendimiento de un data warehouse, creando una base única y unificada para todos tus datos. Como creador, no gestionas el Lakehouse directamente; en cambio, experimentas sus beneficios a través de la velocidad, confiabilidad y potentes funciones de la cadena de herramientas de Arkham.

Cómo el Lakehouse Potencia las Herramientas de Arkham

Nuestra arquitectura Lakehouse es el “cómo” detrás de la experiencia fluida que tienes en las herramientas UI de nuestra plataforma. Cada característica técnica fundamental del Lakehouse está diseñada para habilitar directamente una parte clave de tu flujo de trabajo.

- Pipelines Confiables para el Pipeline Builder The Lakehouse brings full ACID transaction guarantees to your data transformations. When your

Pipeline Builderjob runs a multi-stage pipeline, it executes as a single, atomic transaction. This means a pipeline either succeeds completely or fails cleanly, eliminating the risk of partial updates and data corruption, ensuring your Production datasets are always consistent. - Consultas de Alto Rendimiento en el Playground Tus consultas en el Playground son rápidas porque el Lakehouse utiliza formatos columnarios abiertos (como Apache Parquet) y una arquitectura de cómputo desacoplada. Los datos se almacenan optimizados para consultas, y el motor de consultas puede escalar de forma independiente, asegurando una latencia baja y constante para tu análisis ad-hoc, incluso en conjuntos de datos masivos.

Playgroundare fast because the Lakehouse uses open columnar formats (like Apache Parquet) and a decoupled compute architecture. Data is stored in a query-optimized way, and the query engine can scale independently, ensuring consistently low latency for your ad-hoc analysis, even on massive datasets. - Gobernanza Sin Esfuerzo en el Catálogo de Datos La capacidad de Viaje en el Tiempo de la capa transaccional es la base de las funciones de gobernanza del Catálogo de Datos. Cada cambio en un dataset crea una nueva versión, y el Catálogo mantiene un historial completo y auditable. Esto te permite inspeccionar el estado de tus datos en cualquier momento, rastrear la trazabilidad y depurar con confianza.Time Travel capability of the transactional layer is the foundation of the

Data Catalog'sgovernance features. Every change to a dataset creates a new version, and the Catalog maintains a full, auditable history. This allows you to inspect the state of your data at any point in time, track lineage, and debug with confidence. - Ingesta Flexible a través de Conectores Nuestros Conectores pueden ingerir datos de cualquier formato de forma confiable porque el Lakehouse está diseñado para manejar cualquier formato de datos en almacenamiento de objetos rentable, mientras que la capa transaccional sigue imponiendo una fuerte validación de esquemas al escribir. Esta combinación única te brinda la flexibilidad de un data lake con las garantías de un warehouse, desde el primer paso de tu flujo de trabajo.

Connectorscan reliably ingest data of any shape because the Lakehouse is built to handle any data format on cost-effective object storage, while the transactional layer still enforces strong schema validation on write. This unique combination gives you the flexibility of a data lake with the guarantees of a warehouse, right from the first step of your workflow.

Arkham vs. Arquitecturas Alternativas

Para apreciar los beneficios del Lakehouse gestionado de Arkham, es útil compararlo con las arquitecturas tradicionales que los equipos de datos suelen tener que construir y mantener por sí mismos. La plataforma de Arkham está diseñada para ofrecerte las ventajas de un Lakehouse sin la complejidad de configuración y gestión.

Feature

Data Lakes

Data Warehouses

Arkham Lakehouse (Best of Both)

Storage Cost

✅ Very low (S3)

❌ High (compute + storage)

✅ Very low (S3)

Data Formats

✅ Any format (JSON, CSV, Parquet)

❌ Structured only

✅ Any format + structure

Scalability

✅ Petabyte scale

❌ Limited by cost

✅ Petabyte scale

ACID Transactions

❌ No guarantees

✅ Full ACID support

✅ Full ACID support

Data Quality

❌ No enforcement

✅ Strong enforcement

✅ Strong enforcement

Schema Evolution

❌ Manual management

❌ Rigid structure

✅ Automatic evolution

Query Performance

❌ Slow, inconsistent

✅ Fast, optimized

✅ Fast, optimized

ML/AI Support

✅ Great for ML

❌ Poor ML support

✅ Great for ML

Real-time Analytics

❌ Batch processing

✅ Real-time queries

✅ Real-time queries

Time Travel

❌ Not available

❌ Limited versions

✅ Full version history

Setup Complexity

✅ Simple (but lacks features)

❌ Complex ETL

✅ Zero (Managed by Arkham)

Capacidades Relacionadas

- Visión General de la Plataforma de Datos: Observa cómo el Lakehouse sostiene todo el flujo de datos integrado.

- Connectors: Aprovecha la flexibilidad del Lakehouse para ingerir cualquier formato de datos.

- Pipeline Builder: Construye pipelines confiables respaldados por las garantías de transacciones ACID del Lakehouse.

- Catálogo de Datos: Gobierna y versiona automáticamente tus datos con las capacidades de Viaje en el Tiempo del Lakehouse.

- Playground: Ejecuta consultas de alto rendimiento en conjuntos masivos de datos gracias al motor optimizado del Lakehouse.